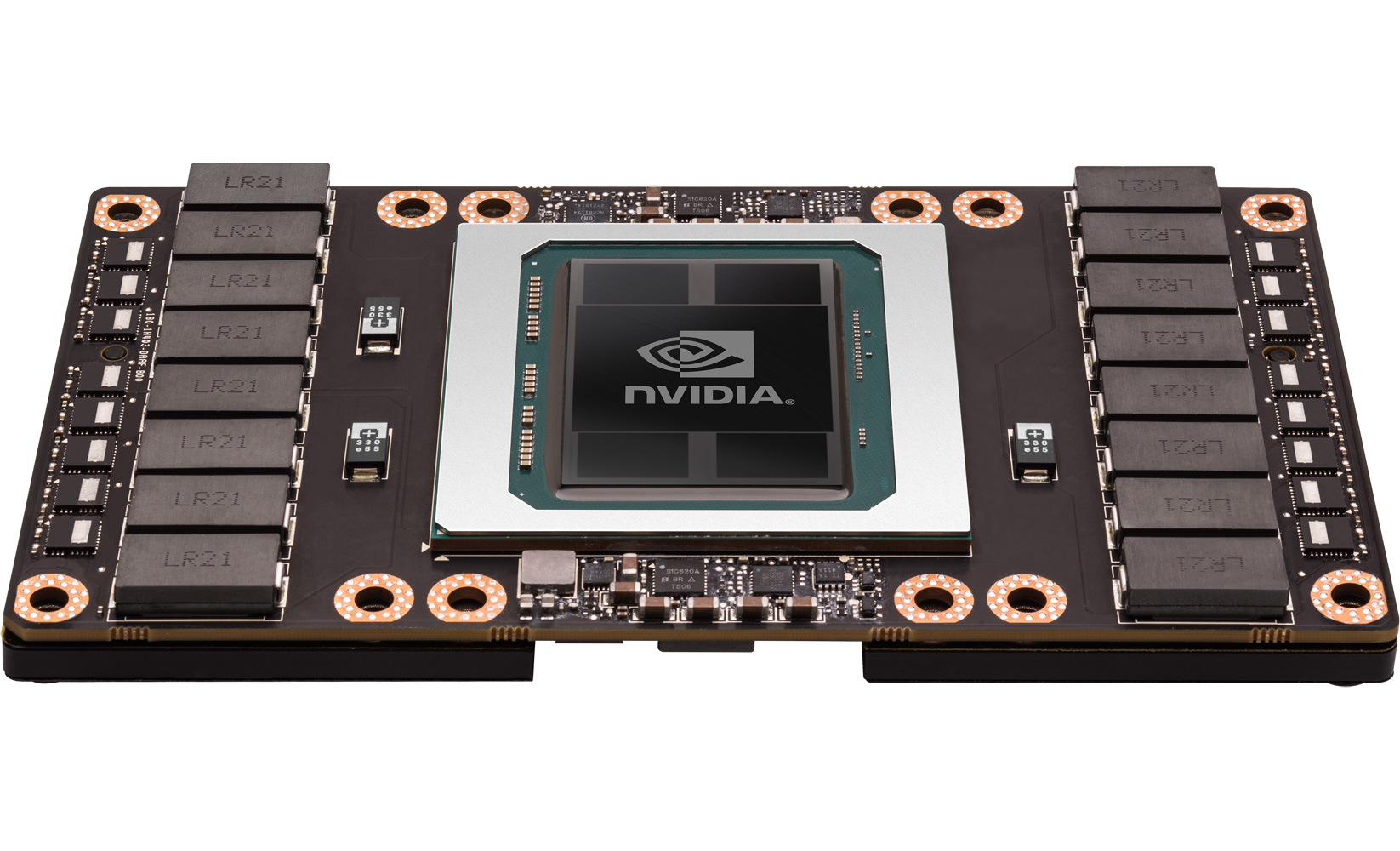

NVIDIA non punta solo al dominio del mercato consumer. I prodotti a listino indirizzati al mondo dell'impresa sono tanti, dalle GPU dedicate alla grafica ai dispositivi pensati per l'High Performance Computing. La combinazione di hardware all'avanguardia in uno spazio ridotto non è semplice da ottenere, ma con l'arrivo di Pascal le cose sono migliorate da questo punto di vista. La compagnia ha fiutato l'opportunità, in quanto da tempo produce macchine potenti ma dalle dimensioni controllate, fra le quali segnaliamo per esempio il Quadro Visual Computing Alliance. NVIDIA ha deciso di fare sul serio con Pascal, proponendo il processore GP100 e la scheda Tesla P100, prodotto ottimizzato per il calcolo a doppia precisione. Uno dei più rilevanti aspetti della GPU riguarda il rinnovato form factor e la tecnologia per le interconnessioni. Nonostante P100 supporti la classica interfaccia PCI-E, NVIDIA ha inserito il pieno supporto ad NVLink, un'interfaccia che consente a più schede grafiche in parallelo di accedere più velocemente alla memoria. Per NVIDIA si è trattato di un passo naturale: le GPU prendono sempre più la forma di CPU vere e proprie, espandendo le loro caratteristiche e la potenza di calcolo, e trasformandosi sempre più in unità a sé stanti. Per tale motivo le operazioni di I/O sono sempre più centrali nella filosofia operativa di questi sistemi.

Ecco NVLink!

Considerato che NVIDIA ha lanciato una nuova interfaccia e un nuovo form factor per il mercato server, risulta assai chiaro il bisogno di un'aggiornata infrastruttura. I partner della società di Santa Clara produrranno i propri sistemi con all'interno Tesla P100, ma attualmente nessuno è ancora stato in grado di creare una macchina che sfrutti al massimo le ultime tecnologie disponibili. E' per questo motivo che NVIDIA ha deciso di costruire da sé il primo server con Tesla P100 a bordo, chiamato proprio DGX-1. La scelta si è rivelata essenziale per non allungare il gap con i competitor del settore, seppur ciò comporti per la casa americana una grossa sfida: supportare lo sviluppo e il software di un prodotto di tale genere non è per niente un compito semplice, vista la sua complessità. DGX-1 possiede infatti ben otto schede grafiche Tesla GP100 in configurazione ibrida, con NVLink a farla da padrone, che consente un bandwidth davvero spaventoso nello scambio dati fra le varie unità di calcolo. Stiamo infatti parlando di un collegamento bidirezionale, quindi full-duplex, fino a 20 GB/s in trasmissione e 20 GB/s in ricezione per linea. Sappiamo che ogni GPU possiede 4 links, per cui la larghezza di banda arriva a 80/80 GB/s.

Come anticipato, le schede sono otto e con quattro collegamenti ogni GPU non riesce ovviamente ad essere linkata a tutte le altre.Le unità di calcolo non reciprocamente collegate passano attraverso il comune switch PCIe, controllato dalla CPU. Questo schema viene chiamato NUMA (Non-Uniform Memory Access), poiché c'è la necessità di dover compiere un "salto" aggiuntivo per comunicare con una determinata scheda. NVLink comunque abilita la lettura, la scrittura e le operazioni di memoria atomiche contemporaneamente, caratteristica mai stata disponibile prima d'ora. NVIDIA ha affermato che la tecnologia è più di un semplice "backbone" per le interconnessioni, essendo tra l'altro molto diversa dalla PCI Express.

Specifiche e caratteristiche di DGX-1

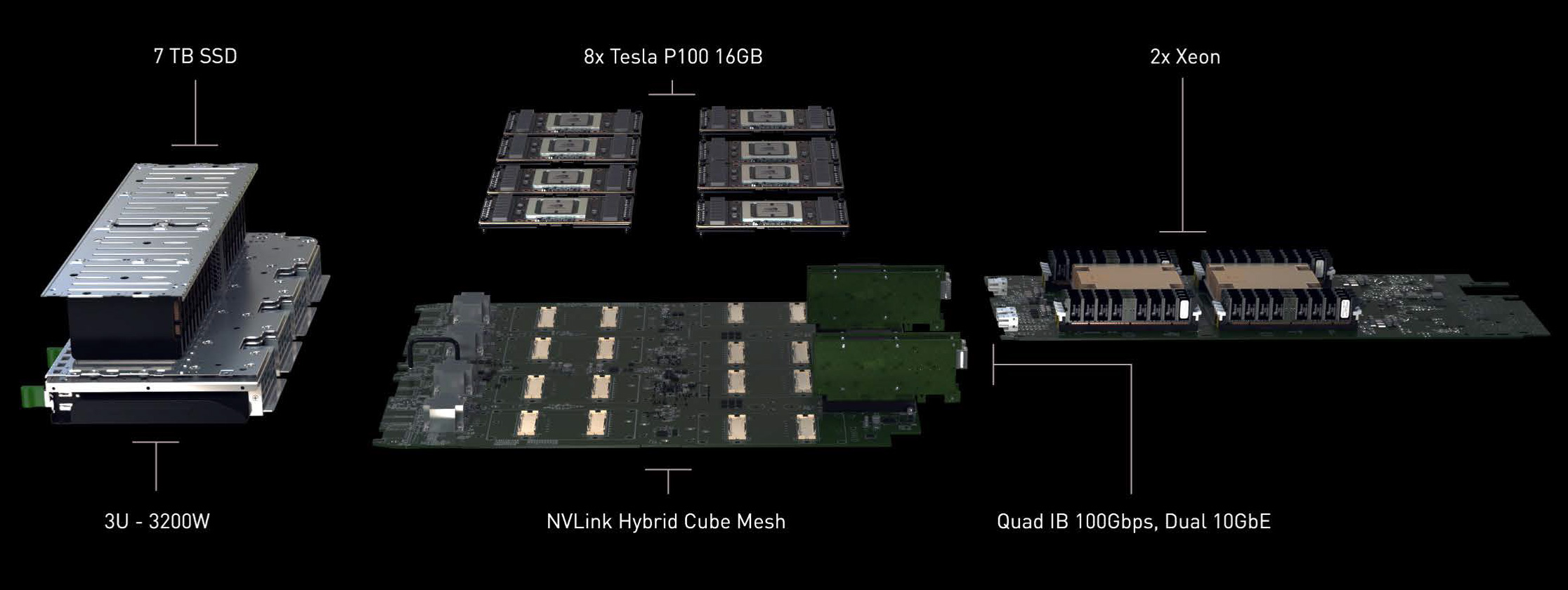

Tornando al server DGX-1, sappiamo che - assieme alle otto Tesla - esso presenta due processori Intel Xeon. Sotto la scocca c'è infatti una coppia di CPU Intel Xeon E5-2698, per un totale di ben 32 core. La memoria RAM a bordo è fissata a 512 GB in tecnologia DDR4, frequenza di 2133 MHz e formato LRDIMM. Sul fronte storage segnaliamo quattro SSD Samsung PM863 da 1,92 TB ciasciuno, mentre per il networking DGX-1 ospita un doppio connettore Gigabit Ethernet e quattro EDR Infiniband. Questi ultimi sono atti a portare la scalabilità al livello successivo, in quanto supportano dei cluster esterni che possono incrementare di molto le prestazioni generali. L'alimentatore che muove il tutto non poteva che essere potente, con 3.200 W disponibili - soltanto le otto Tesla consumano ben 2.400 Watt!

Sul piano fisico, le schede grafiche sono separate dal resto dei componenti, come processori e RAM. Esse sono disposte su una board particolare, che le rende compatibili con NVLink. Ogni unità grafica richiede ben 800 pin, 400 per la PCIe (e la corrente) ed altri 400 per NVLink stesso, con un totale di circa di 1.600 linee aggiuntive che consentono anche una più semplice integrazione con il resto del sistema.

L'alimentatore e gli SSD sono sulla sinistra delle Tesla, in due vani di metallo separati, mentre le due CPU Xeon sono all'estrema destra. Per tenere a bada il calore di tutto questo hardware non conosciamo di preciso che metodologia NVIDIA abbia deciso di integrare sotto la scocca, ma senza dubbio ci troviamo di fronte ad una soluzione a vapor chamber. Gli heatsink sul top sono dipinti di verde e appaiono piuttosto standard.

NVIDIA nel settore server

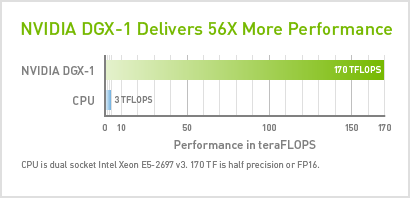

Nonostante la società statunitense abbia deciso di costruire questo sistema prima di tutto per gettarsi in nuovo campo, che prevede la continua ricerca ed implementazione di tecniche hardware e software per il supporto del DGX-1 stesso, la macchina può essere già tranquillamente sfruttata come mezzo di lavoro. Le otto Tesla forniscono un totale di 26.672 CUDA cores sotto il cofano e 128 GB di VRAM, che danno accesso ad una potenza computazione di 170 TFLOPs FP16 e di 85 TFLOPs FP32. Essendo un server destinato all'utilizzo HPC non poteva chiaramente mancare il supporto alle operazioni a doppia precisione (FP64) e all'ECC (Error Correction Code), tecnica che migliora l'affidabilità e la tolleranza agli errori. DGX-1 è così un sistema molto versatile, che verrà probabilmente sfruttato per le applicazioni di deep learning e per le reti neurali prima di tutto, settori in cui le operazioni mixed precision (FP16) sono assolutamente di primaria rilevanza. NVIDIA spera che attorno al suo sistema si possa creare una sorta di community così che, insieme ai i suoi tool ed SDK,si possa costituire il preludio di una affermazione più concreta nell'ambito server. Produrre un box come DGX-1 mette NVIDIA direttamente in concorrenza con gli altri giganti del settore, come Dell, IBM ed HP, che senza alcun dubbio presenteranno presto le loro risposte. Se sia una strategia o meno a lungo termine ciò è ancora poco chiaro, in quanto molto dipende da quale sarà la diffusione del primo, vero server di NVIDIA.

DGX-1 dovrebbe essere disponibile intorno al primo quarto del 2017, anche se nei primi mesi dall'uscita sarà disponibile solo a determinati clienti. Lo scopo di tale scelta è semplicemente dovuta ad una sorta di controllo qualità, funzionale prima del rilascio del prodotto su larga scala, che dovrebbe comunque avvenire in modo graduale.

NVIDIA DGX-1

NVIDIA DGX-1

Coloro che desiderano acquistare il server di NVIDIA dovranno sborsare 129.000 dollari. La società di Santa Clara si è dimostrata essere molto sicura dei suoi mezzi, affermando che a tale prezzo venderà molti esemplari. Per quanto ciò possa essere un’incognita, il fatto certo è che si tratta di una soluzione dall’enorme potenza computazionale. Possibile che comunque il suo valore di mercato scenderà nei prossimi mesi, e che questo prezzo riguardi dunque solo i clienti che desiderano acquistarla subito. NVIDIA ha messo questa macchina a disposizione dei primi acquirenti, principalmente Università, ma si dovrà attendere il 2017 per una sua disponibilità completa.

Coloro che desiderano acquistare il server di NVIDIA dovranno sborsare 129.000 dollari. La società di Santa Clara si è dimostrata essere molto sicura dei suoi mezzi, affermando che a tale prezzo venderà molti esemplari. Per quanto ciò possa essere un’incognita, il fatto certo è che si tratta di una soluzione dall’enorme potenza computazionale. Possibile che comunque il suo valore di mercato scenderà nei prossimi mesi, e che questo prezzo riguardi dunque solo i clienti che desiderano acquistarla subito. NVIDIA ha messo questa macchina a disposizione dei primi acquirenti, principalmente Università, ma si dovrà attendere il 2017 per una sua disponibilità completa.